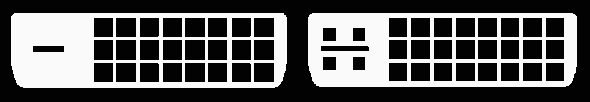

On parle souvent de prise DVI, en oubliant de mentionner le type : DVI-D, DVI-D (ou DVI-A, moins courant).

Et pourtant vous pouvez avoir quelques surprises en achetant une carte graphique récente.

Impossible de connecter mon vieil écran en VGA, mais pourquoi donc ? Quel adaptateur ou convertisseur acheter ?

Digital Visual Interface (DVI)

Le DVI est un type de connexion vidéo pour relier une carte graphique à un dispositif d'affichage tel qu'un écran pour la plupart du temps.

L'interface est apparue avec les écrans "plats", car les écrans cathodiques n'acceptaient qu'un signal analogique. Comme dans toute transition cela s'est fait en douceur puisque les prises DVI-I sont apparues sur les écrans. Ce brochage permet de véhiculer un affichage analogique ou numérique, mais pas les deux en même temps, et ne réalise aucune conversion.

L'analogique a tendance à dégrader le signal, de façon plus ou moins visible selon la qualité des composants et des câbles, contrairement au numérique qui arrive intègre vu la faible longueur du câble. Il est parfois impossible de faire la différence à l’œil, tout comme parfois ça peut sauter aux yeux.

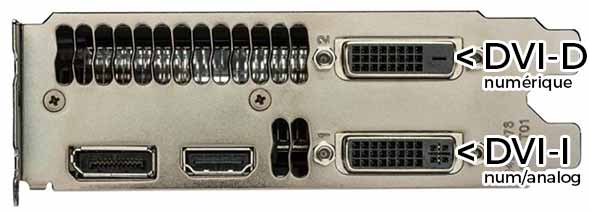

Jusqu'ici les carte graphiques disposaient d'une prise DVI-I et il était tout à fait possible de continuer d'utiliser un signal analogique. Aucun avantage par rapport au VGA, sinon le brochage un peu moins fragile. Certaines cartes proposaient une sortie DVI-I et une sortie DVI-D, c'est le cas de GTX 770 :

Je résume :

- DVI-I : numérique ou analogique (compatible VGA)

- DVI-D : numérique uniquement

Moyen mnémotechnique: DVI-I comme "intelligent" et qui sait donc faire les deux (analogique ou numérique). L'autre (DVI-D) c'est donc numérique only.

La rupture

Avec le temps les fabricants de cartes font évoluer leurs cartes graphiques et l'analogique a disparu, discrètement.

Pourquoi discrètement ? Car pour des questions de compatibilité de connectique on a continué de trouver des sorties DVI-I sur les cartes graphiques, alors qu'aucun signal analogique ne pouvait en sortir.

C'était tout simplement pour vous éviter d'avoir un racheter un câble DVI, qui lui n'est pas typé analogique ou numérique (ce ne sont que des câbles en cuivre après tout). Les embouts des câbles eux sont plus souvent en DVI-D pour la même raison : le jour où vous basculez en numérique vous n'aurez pas à rachetez de câble (contrairement aux câble DVI-I à cause du détrompeur qui ne rentre pas dans le DVI-D).

Bref c'est un peu n'importe quoi, et tout le monde a participé à ce bordel.

Les adaptateurs, presque inutiles

Il existe des adaptateurs DVI vers VGA, là encore pour éviter de changer de câble, voir d'écran. Comme si ce n'était pas assez compliqué comme ça on rajoute par dessus des adaptateurs chinois (dealextreme, banggood, aliexpress...) aussi douteux que bon marché.

Ces adaptateurs fonctionnent uniquement si la sortie de votre carte graphique est analogique. Dans le cas contraire vous n'aurez rien à l'écran car le VGA ne peut pas véhiculer autre chose que l'analogique.

Et là encore il ne faut pas se fier à la connectique car on trouve de tout : DVI-D vers VGA et DVI-I vers VGA. Le DVI-D peut paraître une aberration car en théorique c'est du numérique uniquement me direz-vous... mais rappelez-vous que les connectiques des cartes graphiques ne respectent pas nécessairement le connecteur à utiliser (analogique ou numérique) donc un adaptateur DVI-D est logique car il rentre aussi dans un port DVI-I.

Il suffit de regarder les commentaires sur Amazon qui disent que l'adaptateur ne fonctionnent pas pour comprendre que les gens mélangent tout. Brancher un adaptateur DVI-VGA sur une carte graphique qui ne sort pas de signal analogique pour aller sur un écran VGA... il est clair que ça ne fonctionnera jamais. Certains ont une sortie analogique et diront qu'ils sont satisfaits du produit, mettant encore un peu plus le doute à celui qui veut acheter l'adaptateur.

La solution : le convertisseur actif

J'ai acheté une GTX 1060 6GB il y a quelques mois, ma première carte graphique car je ne suis pas un "gamer". Et puis j'ai goûté à Steam et à sa simplicité, et j'ai craqué. Je cherchais aussi une carte graphique pour pouvoir ré-encoder certaines vidéos, et avec le GPU ça déboîte!

Sur ma GTX 1060 6GB (WindForce OC) j'ai :

- 2 sorties DVI-D

- 1 sortie HDMI

- 1 sortie DisplayPort

J'ai 2 écrans : un vieux qui n'accepte que du VGA et l'autre qui accepte HDMI et VGA. Je vais donc connecter un câble HDMI sur le plus récent mais comment connecter le second ? J'ai cherché un convertisseur DVI-D vers VGA, à ne pas confondre avec adaptateur, mais je n'ai rien trouvé dans des prix raisonnables.

J'ai donc cherché un convertisseur DisplayPort vers VGA et j'ai trouvé mon bonheur pour moins de 10€. Il en existe un bon paquet à moins de 10 € :

Si vous avez aussi besoin de récupérer le son certains proposent une sortie son via un jack 3,5mm, pour ma part j'utilise le jack natif de ma tour.

La qualité d'affichage est parfaite, je n'ai aucune ligne ou perturbation, les couleurs ne sont pas altérées.

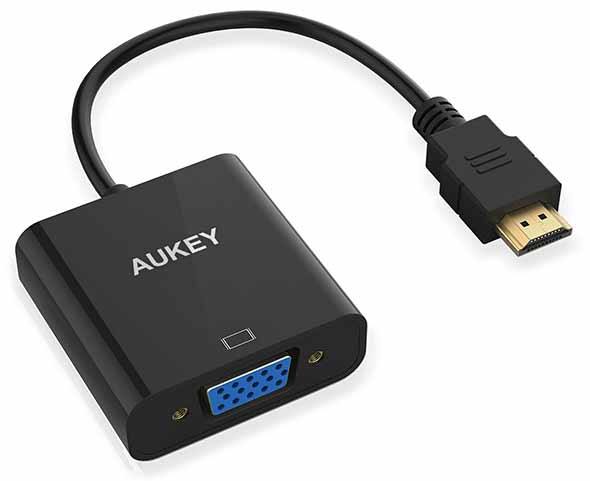

A la différence de l'adaptateur qui est passif et ne change que le brochage un convertisseur va transposer le signal numérique vers de l'analogique grâce à des composants électroniques alimentés par une des broches du DisplayPort ou HDMI.

Conclusion

Ce petit convertisseur va me permettre de ne pas jeter mon écran LCD qui fonctionne très bien et pour moins de 10€ je n'ai rien à redire. Je vous conseille d'opter pour les convertisseurs qui ont le câble le plus épais possible, c'est synonyme d'une bonne qualité de signal, et vérifier aussi les commentaires négatifs.

Au passage j'ai aussi acheté ce convertisseur HDMI vers VGA à 7€ environ, ça peut toujours servir avec un bricolage Raspberry Pi ou avec un laptop récent qui n'a pas de VGA (pour les réunionites du lundi matin, toi-même tu sais) :

Si vous cherchez un mini-DisplayPort (mac...) vers VGA il existe des convertisseurs.

(6 vote(s),

(6 vote(s),

26 commentaires

Avec le temps les fabricants de cartes font évoluer leurs cartes graphiques et le numérique a disparu, discrètement.!!!

il me semble que c'est le contraire, avec le temps L'ANALOGIQUE" a disparu, ou du moins est amené à disparaître

@ITPPA: coquille corrigée, merci

Bonjour,

Depuis environ une semaine, je cherche à brancher un deuxième écran sur ma carte graphique sans trop de succès.

J'ai 4 sorties:

1 DVI A

1 DVI D

1 HDMI

1 display port

Mon set up se compose de deux écrans VGA. Un premier est branché à l'aide d'un adaptateur classique DVI A -> VGA;

Cependant pour le deuxième j'ai acheté un adaptateur HDMI -> VGA mais celui ci ce fonctionne pas (écran détecté mais noir).

L'adaptateur est comme sur la photo de l'article.

La question est: dois-je acheter un adaptateur DisplayPort vers VGA ?

Et pourquoi le HDMI ne marche pas ?

@Maho: bonjour,

dans les propriétés d'affichage est-ce que ton PC détecte l'écran ? Il faudrait faire un test avec un autre écran pour éliminer l'un ou l'autre (adaptateur ou écran)

Oui l'écran est détecté.

Après l'adaptateur est neuf et l'écran était utilisé sur un autre pc sans problème.

Je suis allé voir le vendeur il m'a parlé d'un problème de résolution du deuxième écran. Est ce possible ?

@Maho: tu n'as pas un autre périphérique HDMI pour tester ? laptop, chromecast, console ou autre ?

J'ai mon ordi portable pour tester.

Mais du coup c'est pour tester l'adaptateur ?

@Maho: oui pour vérifier qu'il fonctionne bien

Alors j'ai testé avec mon ordi portable et rien se s'affiche nn plus.

Mais mon ecran a une résoltion max de 1440x900 et l'hdmi envoie du 1080...

@Maho: la résolution s'adaptera à l'écran. Tu as bien activé la sortie externe ? quel adaptateur as-tu acheté, celui que j'indique dans le billet ?

Bonjour, en lisant ton article, si j'ai bien compris, l'adaptateur que tu a mis dans ton article, ne fournit pas l'audio, mais, alors, lequel prendre pour avoir aussi le son?

@Sophie: aucun DVI ne fait circuler de son

Bonjour,

Je viens également discuter de mon problème. J'ai un écran Full HD avec seulement une sortie VGA. Je viens d'acheter ma nouvelle CG (une 1060 OC) qui possède elle, 3 DisplayPort, 1 HDMI et un DVI-D.

J'ai donc été confronté au même problème que la plupart des gens qui viennent lire ton billet, à savoir l'impossibilité de relier l'écran à la CG.

J'ai donc suivi ton conseil en me procurant le convertisseur DisplayPort -> VGA en vente sur Amazon mais je me retrouve avec un écran noir, aucun signal vidéo détecté.

Alors évidemment, j'ai testé mon setup sur ma TV (une LG disposant d'une entrée VGA) mais c'est pareil, aucun signal détecté.

Dois-je en conclure que ce sont ces bidules qui ne fonctionnent absolument pas où juste que je suis mal tombé ? Parce que je ne suis pas le seul dans ce cas de figure.

Je ne sais pas quoi faire 😕 J'ai pas la possibilité de changer d'écran de PC, donc un convertisseur/adaptateur HDMI -> VGA ou DisplayPort -> VGA aurait été parfait.

Merci d'avance.

@Wesley: bonjour, j'utilise justement cet adaptateur sur une 1060 OC (gigabyte) et je n'ai aucun problème. Es-tu sûr que ta sortie Display est active ? regarde dans les paramètres d'affichage voir si l'écran est détecté ou non et déconnecte toutes les autres sorties pour démarrer uniquement sur l'adaptateur

Re-bonjour.

Comment activer la sortie DisplayPort ? C'est du Plug'n'Play normalement.

En fait, y'a du nouveau mais c'est pas encore ça. J'ai connecté ma CG en HDMi à la TV mais également en VGA via l'adaptateur (toujours sur la TV). Le boot s'est lancé correctement et dans les options de configuration Nvidia, il y avait bien les deux sorties et l'écran de détecté. J'ai indiqué que je voulais l'écran branché en VGA comme moniteur principal et j'ai procédé au redémarrage en débranchant le HDMI. Donc seulement branché en VGA sur la tv. Mais le boot ne s'est pas fait. L'écran passe en veille.

J'ai alors testé avec l'écran PC, pareil. Mais si je branche le moniteur en VGA + la tv en HDMI, le PC se lance correctement. Le moniteur branché en VGA en principal et la TV en HDMI en secondaire.

Après plusieurs recherches, j'ai vu qu'il était question d'un pin connecté sur le câble DisplayPort qui ne devrait pas l'être. Le fameux pin 20. Seul 19 devrait être branchés.

Bref, je crois que je vais tenter ma chance avec un adaptateur HDMi -> VGA pour voir si ça résout mon problème et reviendrai ici pour donner des détails.

bonjour , je vous explique mon soucis . Je viens d'acheter un ecran Vga/dvi . je possede un cable Hdmi d'un coté et comme une prise dvi-d de l'autre mais celle ci n'a pas toutes ses broches il en manque 9 au milieu . En brancheant mon ecran a mon ordinateur hdmi , cela fonctionne sans soucis . Par contre quand je veux sortir de mon raspberyy Pi3 via la sortie hdmi et rentrer avec ce cable dans la prise Dvi-d de l'ecran , apparemment je n'ai aucune image , quel est le soucis ? j'aurais voulu vous mettre des captures d'ecrans des cables mais apparemment pas possible , merci de votre aide

@gaetan: tu as un DVI single-link, mais il ne limite que la bande passante (et donc les résolutions très importantes). Il y a de nombreux câbles qui ne fonctionnent pas avec un RPI, tu peux déjà jouer avec les différents réglages de config.txt https://www.raspberrypi.org/forums/viewtopic.php?t=34061#p328079

Bonjour

voici mon problème:

j'ai un Macbook pro 17 de 2011( le dernier modèle 17 pouces) qui a une sortie minidisplay. si je veux brancher une télé lcd équipée d'une entrée DVI-I, il reconnait bien la présence d'un deuxième écran, mais rien ne s'affiche sur la télé, que je sélectionne recopie video, ou non.

j'ai un adaptateur minidisplay vers DVI (rien de précisé dessus)

n'ayant pas de cable dvi male/male, je passe par minidvi vers hdmi ( cable mac) et adapteur hdmi vers DVI

MAIS point d'image sur la télé ( 2ème écran reconnu par le mac, pourtant )

Bonjour

J'ai un lecteur vidéo Blu-ray avec connexion optique...ok. Mais je dispose aussi d'un classique lecteur de DVD. Certain de mes DVD, normalement lisibles par le Blu-ray, en fait, ne le sont pas car bug...image qui se fige...etc... par contre lecture parfaite avec mon lecteur DVD. D’où mon désir de continuer à m'en servir. Je viens d'acheter une nouvelle TV OLED. Surprise il n'y a plus de brachement possible PERITEL. Or mon "vieux" lecteur DVD n'a de branchement possible qu'avec PERITEL !

Quelqu'un pourrait-il donc me renseigner sur ce qu'il faut que j'achète comme convertisseur PERITEL-HDMI. J'en ai vu 2 ou 3 types à la vente sur certains sites mais je ne sais pas lequel prendre.

Merci de vos conseils

Bonsoir,

Merci de toutes ces explications.

Si j'ai bien compris une carte graphique avec seulement un dvi d ne transmet pas de signal analogique ?

Donc un adaptateur du genre : http://amzn.to/2zVjGeq ne servira à rien ?

Il faudra plutôt un convertisseur ou adaptateur actif du genre : http://amzn.to/2ltIYfr

c'est bien cela ?

sur une carte graphique :

Dvi i => la carte envoi un signal analogique et numérique

Dvi d => la carte n’envoie pas de signal analogique et dans ce cas il faudra un convertisseur pour avoir de l'analogique

j'ai compris ??

Merci

@Serge152: tout à fait, tu as parfaitement compris

@Rackham 13: un convertisseur Peritel (SCART) vers HDMI coûte assez cher, regarde ce que tu as comme connectique derrière ton lecteur DVD, tu as probablement du RCA (CINCH) :

Pour l'audio tu as aussi peut-être une sortie audio numérique : coaxiale (prise ronde CINCH ou optique (optical) : prise carrée avec un cache plastique noir ou gris qui revient en place tout seul

Bonjour,

Deux questions:

1-J'ai, depuis peu, une carte mère Msi 270 avec sortie dvi-d et hdmi donc problème car mon ecran est vga. J'achète un convertisseur connect land hdmi vers vga. Rien pas de signal.

Je teste l'ecran ainsi équipé sur une freebox, ça marche par intermittence.

Une idée?

2-j'ai un cordon hdmi-s (simple). Est-ce compatible avec les prise dvi-d?

Merci d'avance

@Sellig: il faut faire un test croisé avec un autre écran pour mettre en défaut l'adaptateur (ou pas)

Bonjour,

Deux questions:

1-J'ai, depuis peu, une carte mère Msi 270 avec sortie dvi-d et hdmi donc problème car mon ecran est vga. J'achète un convertisseur connect land hdmi vers vga. Rien pas de signal.

Je teste l'ecran ainsi équipé sur une freebox, ça marche par intermittence.

Une idée?

2-j'ai un cordon hdmi-s (simple). Est-ce compatible avec les prise dvi-d?

Merci d'avance

@Mr Xhark: merci pour la reponse. Bonne journée

Super article, j'avais de la misère avec de vieux cables et un vieil écran et j'ai réussi à démêler le tout grâce à vous. Un grand merci!